यह श्वेत-पत्र प्रधान वैज्ञानिक सलाहकार (OPSA) के कार्यालय ने जारी किया है। यह श्वेत - पत्र एआई गवर्नेंस के लिए पारंपरिक "कमान-और-नियंत्रण" विनियमों से हटकर एक “तकनीकी-कानूनी मॉडल” की ओर बढ़ने का प्रस्ताव करता है।

तकनीकी-कानूनी ढांचे के मुख्य सिद्धांत

- डिजाइन द्वारा गवर्नेंस: कानूनी और नैतिक आवश्यकताओं को डिजाइन के चरण में ही AI प्रणालियों में शामिल कर लिया जाता है।

- नवाचार-समर्थक और लचीला विनियमन: नवाचार के साथ जोखिम न्यूनीकरण का संतुलन बनाना।

- जोखिम-आनुपातिक नियंत्रण: AI प्रणालियों के तैनाती के पैमाने और संभावित नुकसान के अनुसार एआई गवर्नेंस की तीव्रता अलग-अलग होती है। साधारण शब्दों में सरकार प्रत्येक AI प्रणाली पर एक ही तरह के सख्त नियम लागू नहीं करेगी। इसके बजाय, नियमों की सख्ती इस पर निर्भर करेगी कि वह प्रणाली समाज या व्यक्ति को कितना नुकसान पहुंचा सकती है।

- मानवीय निरीक्षण: स्वत: होने वाले नुकसान को रोकने के लिए महत्वपूर्ण निर्णय बिंदुओं पर मानवीय निगरानी को बनाए रखा जाता है।

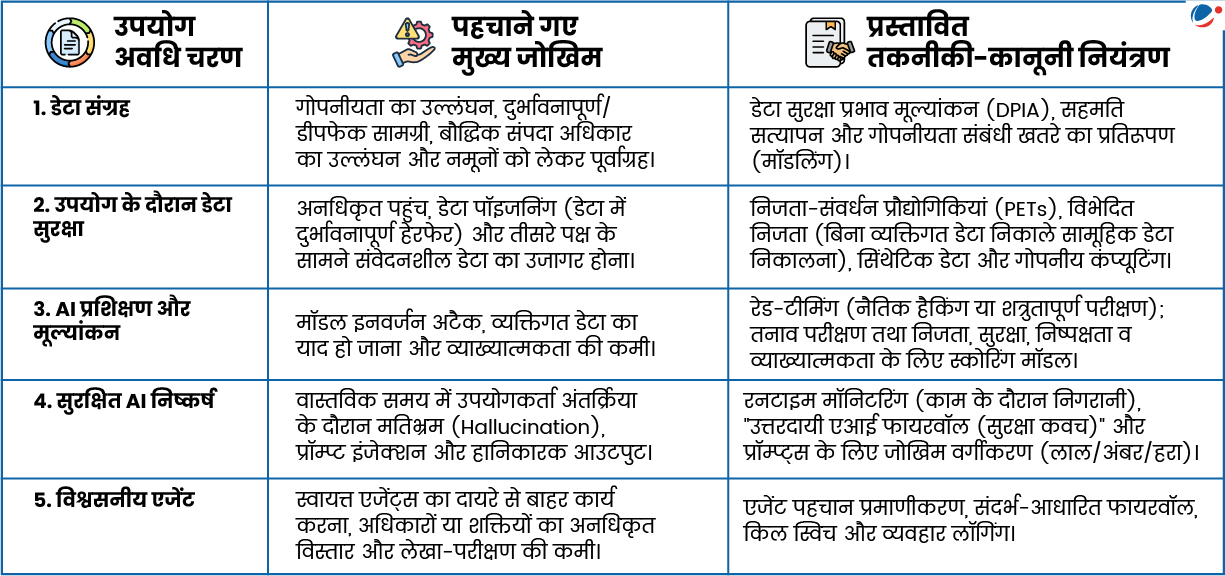

- उपयोग अवधि-आधारित गवर्नेंस: सुरक्षा उपाय डेटा संग्रह और प्रशिक्षण से लेकर तैनाती व उपयोग तक पूर्ण AI उपयोग अवधि में कार्य करते हैं। (इन्फोग्राफिक देखें)

AI उपयोग अवधि और प्रस्तावित नियंत्रण

कार्यान्वयन में चुनौतियां

- गोपनीयता बनाम प्रदर्शन: विशेष रूप से कम प्रतिनिधित्व वाले भाषाई और सांस्कृतिक समूहों के लिए बड़े पैमाने पर डेटा मिटाने से मॉडल का प्रदर्शन कम हो सकता है।

- AI उपयोगकर्ताओं और AI विषयों के बीच अंतर: स्वास्थ्य सेवा और लोक सुरक्षा जैसे भारतीय कल्याणकारी संदर्भों में, नागरिक अक्सर उपयोगकर्ता की बजाय 'विषय' (subjects) होते हैं, जिनके पास परिणामों का विरोध करने की क्षमता कम होती है।

- सीमा-पार अनुरूपता और प्रवर्तन: विदेशों में प्रशिक्षित मॉडल्स में भारतीय सुरक्षा उपाय शामिल नहीं हो सकते हैं। इससे विनियामक समस्याएं उत्पन्न होती हैं।

- सटीकता के साथ अनुपालन का संतुलन: तकनीकी-कानूनी उपायों को लागू करने से संभावित रूप से AI प्रणालियों की सटीकता प्रभावित हो सकती है।

आगे की राह

|